Поисковые системы используют специальные программы — краулеры (от англ. «crawler» — «обходчик»), которые сканируют веб-страницы. У «Яндекса» и Google они называются YandexBot и GoogleBot. Их основная задача — собирать данные о сайте и передавать их алгоритмам для оценки качества контента.

Зачем нужна индексация?

Краулеры постоянно сканируют сайты, фиксируя все изменения. Когда поисковая система индексирует страницу, она добавляет ее в свою базу данных, чтобы затем показывать пользователям по соответствующим запросам. Если сайт не попадает в индекс, он остается невидимым для поиска, а значит, не привлекает новых посетителей.

Как проходит процесс индексации?

Как работает индексация сайтов: важный этап SEO и продвижения сайтов в Уфе

Индексация состоит из двух основных этапов:

1. Сканирование

Когда краулер заходит на страницу, он первым делом проверяет файл robots.txt — в нем указано, какие разделы сайта можно просматривать, а какие закрыты от индексации. Затем робот анализирует META-теги, заголовки, тексты, изображения и другие элементы. На основе этих данных он определяет содержание страницы.

2. Оценка и добавление в индекс

После сбора информации поисковая система анализирует качество контента. Алгоритмы оценивают такие параметры, как:

- Наличие ключевых слов – текст должен содержать поисковые запросы, но без переспама.

- Уникальность контента – поисковики не индексируют копии страниц, а сайты с плагиатом могут получить санкции.

- Полезность информации – алгоритмы учитывают, насколько контент решает проблему пользователя.

Если страница соответствует критериям качества, она попадает в базу поисковой системы и становится доступной для пользователей.

Как ускорить индексацию?

Поисковые системы индексируют сайты по своему расписанию, но можно ускорить этот процесс:

- Добавить сайт в «Вебмастер» Яндекса или Google Search Console – это поможет краулерам быстрее обнаружить новые страницы.

- Настроить внутреннюю перелинковку – ссылки между страницами помогают роботам быстрее находить новый контент.

- Создать XML-карту сайта (sitemap.xml) – это позволяет поисковику легче ориентироваться в структуре.

- Обновлять контент – активные сайты индексируются чаще, чем статичные.

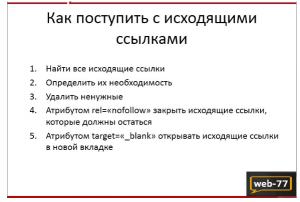

Как скрыть страницу от индексации?

Иногда необходимо закрыть страницу от поисковых систем. Это можно сделать несколькими способами:

- Добавить в код страницы META-тег robots с параметром noindex.

- Указать запрет в файле robots.txt.

- Закрыть доступ через авторизацию (краулеры не индексируют страницы с ограниченным доступом).

Итог

Индексация – ключевой этап SEO. Без нее сайт не появится в поисковой выдаче, а значит, не принесет трафик. Чтобы ускорить процесс, важно регулярно обновлять контент, использовать внутренние ссылки и работать с инструментами для веб-мастеров. Грамотная индексация — залог успешного продвижения сайтов в Уфе и других регионах.